La historia de la física cuántica, así como la de la mayoría de las teorías y descubrimientos científicos, es una historia que comienza con varios descubrimientos diferentes: en 1838 comienza con el descubrimiento por parte de Michael Faraday de los rayos catódicos; descubrimientos varios de radiación por parte de Gustav Kirchoff; unas teorías de 1877 de Ludwig Boltzmann relativas al sistema físico de los estados de energía, finalizando con la hipótesis de Max Planck de 1900 en la cual postulaba que los sistemas atómicos que irradian energía pueden ser divididos en varios elementos de energía.

Luego, uno de los científicos más prolíferos de la historia, Albert Einstein, continuó en 1905 con los efectos reportados por Hertz en 1887, los cuales eran consistentes con los hallazgos de Max Planck, de que la luz en sí misma está hecha de partículas cuánticas individuales, los cuales recibieron el nombre de "fotón" en 1826.

La física

cuántica, también conocida como mecánica ondulatoria, es la rama de la física

que estudia el comportamiento de la materia cuando las dimensiones de ésthttp://www.ojocientifico.com/2011/07/26/historia-de-la-fisica-cuanticaa son

tan pequeñas, en torno a 1.000 átomos, que empiezan a notarse efectos como la

imposibilidad de conocer con exactitud la posición de una partícula, o su

energía, o conocer simultáneamente su posición y velocidad, sin afectar a la

propia partícula (descrito según el principio de incertidumbre de Heisenberg). z6z

Surgió a lo

largo de la primera mitad del siglo XX en respuesta a los problemas que no

podían ser resueltos por medio de la física clásica

El término radiación se refiere a la emisión continua de energía desde

la superficie de cualquier cuerpo, esta energía se denomina radiante y es

transportada por las ondas electromagnéticas que viajan en el vacío a la

velocidad de 3·108 m/s . Las ondas de radio, las radiaciones

infrarrojas, la luz visible, la luz ultravioleta, los rayos X y los rayos

gamma, constituyen las distintas regiones del espectro electromagnético.

Consideremos una cavidad cuyas paredes están a una cierta temperatura.

Los átomos que componen las paredes están emitiendo radiación electromagnética

y al mismo tiempo absorben la radiación emitida por otros átomos de las

paredes. Cuando la radiación encerrada dentro de la cavidad alcanza el

equilibrio con los átomos de las paredes, la cantidad de energía que emiten los

átomos en la unidad de tiempo es igual a la que absorben. En consecuencia, la

densidad de energía del campo electromagnético existente en la cavidad es

constante.

A cada frecuencia corresponde una densidad de energía que depende

solamente de la temperatura de las paredes y es independiente del material del

que están hechas.

|

|

Si se abre un pequeño agujero en el recipiente, parte de la radiación

se escapa y se puede analizar. El agujero se ve muy brillante cuando el

cuerpo está a alta temperatura, y se ve completamente negro a bajas

temperaturas.

|

Históricamente, el nacimiento de la Mecánica Cuántica, se sitúa en el

momento en el que Max Panck explica el mecanismo que hace que los átomos

radiantes produzcan la distribución de energía observada. Max Planck sugirió en

1900 que

- La

radiación dentro de la cavidad está en equilibrio con los átomos de las

paredes que se comportan como osciladores armónicos de frecuencia dada f

.

- Cada oscilador puede absorber o emitir energía de la radiación en una cantidad proporcional a f. Cuando un oscilador absorbe o emite radiación electromagnética, su energía aumenta o disminuye en una cantidad hf .

Efecto fotoeléctrico en la actualidad

La emisión de electrones por metales iluminados con luz de determinada

frecuencia fue observada a finales del siglo XIX por Hertz y Hallwachs. El

proceso por el cual se liberan electrones de un material por la acción de la radiación

se denomina efecto fotoeléctrico o emisión fotoeléctrica. Sus características

esenciales son:

- Para

cada sustancia hay una frecuencia mínima o umbral de la radiación

electromagnética por debajo de la cual no se producen fotoelectrones por

más intensa que sea la radiación.

- La

emisión electrónica aumenta cuando se incrementa la intensidad de la

radiación que incide sobre la superficie del metal, ya que hay más energía

disponible para liberar electrones.

En los metales hay electrones que se mueven más o menos libremente a

través de la red cristalina, estos electrones no escapan del metal a

temperaturas normales por que no tienen energía suficiente. Calentando el metal

es una manera de aumentar su energía. Los electrones "evaporados" se

denominan termoelectrones, este es el tipo de emisión que hay en las válvulas

electrónicas. Vamos a ver que también se pueden liberar electrones

(fotoelectrones) mediante la absorción por el metal de la energía de radiación

electromagnética.

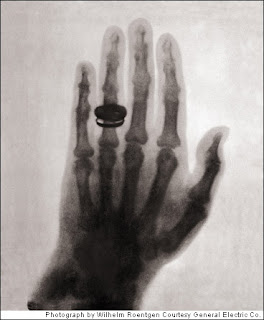

Rayos x

Los rayos X son una radiación electromagnética de la misma

naturaleza que las ondas de radio, las ondas de microondas, los rayos

infrarrojos, la luz visible, los rayos ultravioleta y los rayos gamma.

La diferencia fundamental con los rayos gamma

es su origen: los rayos gamma son radiaciones de origen nuclear que se producen

por la desexcitación de un nucleón de un nivel excitado a otro de menor energía y en la

desintegración de isótopos radiactivos, mientras que los rayos X surgen

de fenómenos extranucleares, a nivel de la órbita electrónica, fundamentalmente

producidos por desaceleración de electrones. La energía de los rayos X en

general se encuentra entre la radiación ultravioleta y los rayos gamma

producidos naturalmente. Los rayos X son una radiación ionizante porque al interactuar con

la materia produce la ionización de los átomos de la misma, es decir, origina

partículas con carga (iones).

MODELO CUANTICO DEL ATOMO DE BOHR

Niels Bohr se basó en el átomo de

hidrógeno para realizar el modelo que lleva su nombre. Bohr intentaba realizar

un modelo atómico capaz de explicar la estabilidad de la materia y los

espectros de emisión y absorción discretos que se observan en los gases.

Describió el átomo de hidrógeno con un protón en el núcleo, y girando a su

alrededor un electrón. El modelo atómico de Bohr partía conceptualmente del

modelo atómico de Rutherford y de las incipientes ideas sobre cuantización que

habían surgido unos años antes con las investigaciones de Max Planck y Albert

Einstein. Debido a su simplicidad el modelo de Bohr es todavía utilizado

frecuentemente como una simplificación de la estructura de la materia.

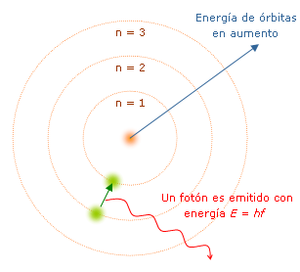

En este modelo los electrones

giran en órbitas circulares alrededor del núcleo, ocupando la órbita de menor

energía posible, o sea la órbita más cercana al núcleo posible. El

electromagnetismo clásico predecía que una partícula cargada moviéndose de

forma circular emitiría energía por lo que los electrones deberían colapsar

sobre el núcleo en breves instantes de tiempo. Para superar este problema Bohr

supuso que los electrones solamente se podían mover en órbitas específicas,

cada una de las cuales caracterizada por su nivel energético. Cada órbita puede

entonces identificarse mediante un número entero n que toma valores desde 1 en adelante.

Este número "n" recibe el nombre de Número Cuántico Principal.

Bohr supuso además que el momento

angular de cada electrón estaba cuantizado y sólo podía variar en fracciones

enteras de la constante de Planck. De acuerdo al número cuántico principal

calculó las distancias a las cuales se hallaba del núcleo cada una de las

órbitas permitidas en el átomo de hidrógeno.

Estos niveles en un principio

estaban clasificados por letras que empezaban en la "K" y terminaban

en la "Q". Posteriormente los niveles electrónicos se ordenaron por

números. Cada órbita tiene electrones con distintos niveles de energía obtenida

que después se tiene que liberar y por esa razón el electrón va saltando de una

órbita a otra hasta llegar a una que tenga el espacio y nivel adecuado,

dependiendo de la energía que posea, para liberarse sin problema y de nuevo

volver a su órbita de origen.

El modelo atómico de Bohr

constituyó una de las bases fundamentales de la mecánica cuántica. Explicaba la

estabilidad de la materia y las características principales del espectro de

emisión del hidrógeno. Sin embargo no explicaba el espectro de estructura fina

que podría ser explicado algunos años más tarde gracias al modelo atómico de

Sommerfeld. Históricamente el desarrollo del modelo atómico de Bohr junto con la

dualidad onda-corpúsculo permitiría a Erwin Schrödinger descubrir la ecuación

fundamental de la mecánica cuántica.

1. Los electrones

orbitan en el átomo en niveles discretos y cuantizados de energía, es decir, no

todas las órbitas están permitidas, tan sólo un número finito de éstas.

2. Los electrones pueden

saltar de un nivel electrónico a otro sin pasar por estados intermedios.

3. El salto de un

electrón de un nivel cuántico a otro implica la emisión o absorción de un único

cuanto de luz (fotón) cuya energía corresponde a la diferencia de energía entre

ambas órbitas.

4. Las órbitas

permitidas tienen valores discretos o cuantizados del momento angular orbital L.

La cuarta hipótesis asume

que el valor mínimo de n es 1. Este valor

corresponde a un mínimo radio de la órbita del electrón de 0.0529 nm. A esta

distancia se le denomina radio de Bohr. Un electrón en este nivel fundamental

no puede descender a niveles inferiores emitiendo energía.

Se puede demostrar

que este conjunto de hipótesis corresponde a la hipótesis de que los electrones

estables orbitando un átomo están descritos por funciones de onda

estacionarias.

En

las interferencias luminosas producidas por dos rendijas paralelas,

aparecen

unos

máximos de intensidad, separados por mínimos (rayas negras). En la

fig.12

se

muestra la imagen de interferencias recogido en una pantalla, y a la derecha

un

gráfico

de la correspondiente intensidad luminosa.

·

Historia A finales del siglo XIX se concluiría que: Teoría atómica:

“Toda materia está compuesta por partículas elementales llamadas átomos”.

Joseph John Thomson: ”La electricidad es un flujo de partículas llamas

electrones”. Por tanto para la época, fenómenos ondulatorios y corpusculares

estarían, cada uno por su lado, bien definido.

·

3. Llegaría entonces el SIGLO XX Aparecerían experimentos como: El

efecto fotoeléctrico analizado por Albert Einstein: La luz, además de poseer

propiedades ondulatorias, tenía propiedades de partícula. La difracción de

electrones: Los electrones se comportaban con propiedades de onda y partícula a

la vez. Entonces ……

·

4. Surgiría la pregunta: ¿PUEDEN LAS PARTÍCULAS TRATARSE COMO ONDAS Y

VICEVERSA?

·

5. La mecánica cuántica daría la respuesta a este interrogante,

planteándose como: “ Un marco de trabajo unificado para comprender que toda

materia puede tener propiedades de onda y propiedades de partícula.”

·

6. Uno de los primeros en aportar para dar este concepto sería:

Louis-Victor de Broglie (1892-1987): “ Toda la materia presenta características

tanto ondulatorias como corpusculares comportándose de uno u otro modo

dependiendo del experimento específico . “

¿QUE ES LA FÍSICA NUCLEAR?

La física nuclear es una rama de la física que estudia las propiedades y el comportamiento

de los núcleos

atómicos. La física nuclear es

conocida mayoritariamente por la sociedad por el aprovechamiento de la energía nuclear encentrales nucleares y en el desarrollo de armas nucleares, tanto de fisión como de fusión nuclear. En un contexto más amplio, se define la física nuclear y de partículas como la rama de la física que estudia

la estructura fundamental de la materia y las interacciones entre las partículas

subatómicas

ESTRUCTURA

DEL NÚCLEO Y FUERZA NUCLEAR

Estructura del núcleo

El conocimiento de la estructura nuclear o estructura

de los núcleos atómicos es

uno de los elementos clave de la física nuclear. En principio, las interacciones de los

constituyentes de los núcleos, los nucleones (protones y neutrones formados, a su vez, por los quarks), están

abarcadas en las predicciones de la cromodinámica

cuántica, dentro de lo que es una teoría

cuántica de campos. Pero debido a

la complejidad de la interacción

fuerte los cálculos son muy complicados y es necesario,

hoy día, recurrir a modelos más sencillos. No existe un único modelo; en el

desarrollo de la física nuclear se han ido creando modelos teóricos para

describir cómo se estructura el material nuclear que constituye los núcleos de los átomos. Algunos de estos modelos son el de la gota

líquida, el modelos de

capas (de partículas independientes, de campo medio, etc.), rotacional, vibracional, vibracional y rotacional,

etc.

MODELOS

NUCLEARES

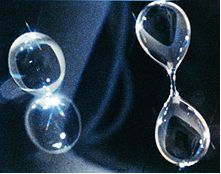

Modelo de gota

líquida

Este es uno de los

primeros modelos de la estructura nuclear, propuesto por Bohr en 1935. En él se describe

el núcleo como un fluido clásico compuesto por neutrones y protones y una fuerza central columbiana

repulsiva proporcional al número de protones Z y con origen en el centro de la gota. La naturaleza mecano-cuántica de estas partículas se introduce a partir delprincipio de

exclusión de Pauli, que establece que fermiones (los nucleones son fermiones) del mismo

tipo no puede estar en el mismo estado cuántico. Así, el líquido es en realidad lo que se conoce como líquido de Fermi, en alusión al gas de Fermi que forman los electrones. Este sencillo modelo reproduce las

principales características de la energía enlace de los núcleos. Es un buen modelo para

predecir niveles energéticos en núcleos poco deformados

Modelo de capas

La idea

del modelo es muy parecida a la planteada para el caso de la corteza

electrónica —el modelo de capas electrónico— .En el

caso de los electrones, teníamos partículas idénticas que se agrupaban en capas

de números cuánticos espaciales distintos (n,l). El número de electrones

permitidos en cada capa venía impuesto por el principio de exclusión de Pauli para fermiones. Los

número cuánticos asociados vienen como resolución de la ecuación de Schrödinger para un potencial coulombiano (~ 1/r) y centrífugo.

Modelo vibracional y rotacional

Este

modelo recurre a la descripción de las vibraciones y rotaciones de la

superficie del núcleo en términos de coordenadas colectivas y así predecir el espectro de frecuencias asociado a los niveles energéticos.

Da buenos

resultados en núcleos poco deformados y parcialmente deformados. También da una

idea cualitativa de altos niveles energéticos en núcleos estables pero muy

deformados, como los isótopos del osmio (187Os, 189Os).

FUERZA

NUCLEAR

Una fuerza nuclear es

aquella fuerza que tiene origen exclusivamente en el interior de los núcleos atómicos. Existen dos fuerzas nucleares, la fuerza fuerte que actúa sobre los nucleones y la fuerza débil que actúa en el interior de los mismos.

Existen dos tipos de

fuerzas nucleares y

Radiactividad

1

|

INTRODUCCIÓN

|

Antoine Henri Becquerel

El físico francés Antoine Henri

Becquerel recibió el Premio Nobel de Física en 1903. Becquerel descubrió la

radiactividad del uranio.

© The Nobel Foundation

Radiactividad, desintegración espontánea

de núcleos atómicos mediante la emisión de partículas subatómicas llamadas

partículas alfa y partículas beta, y de radiaciones electromagnéticas

denominadas rayos X y rayos gamma. El fenómeno fue descubierto en 1896 por el

físico francés Antoine Henri Becquerel al observar que las sales de uranio

podían ennegrecer una placa fotográfica aunque estuvieran separadas de la misma

por una lámina de vidrio o un papel negro. También comprobó que los rayos que

producían el oscurecimiento podían descargar un electroscopio, lo que indicaba

que poseían carga eléctrica. En 1898, los químicos franceses Marie y Pierre

Curie dedujeron que la radiactividad es un fenómeno asociado a los átomos e

independiente de su estado físico o químico. También llegaron a la conclusión

de que la pechblenda, un mineral de uranio, tenía que contener otros elementos

radiactivos ya que presentaba una radiactividad más intensa que las sales de

uranio empleadas por Becquerel. El matrimonio Curie llevó a cabo una serie de

tratamientos químicos de la pechblenda que condujeron al descubrimiento de dos

nuevos elementos radiactivos, el polonio y el radio. Marie Curie también

descubrió que el torio es radiactivo. En 1899, el químico francés André Louis

Debierne descubrió otro elemento radiactivo, el actinio. Ese mismo año, los

físicos británicos Ernest Rutherford y Frederick Soddy descubrieron el gas

radiactivo radón, observado en asociación con el torio, el actinio y el radio.

Pronto se reconoció que

la radiactividad era una fuente de energía más potente que ninguna de las

conocidas. Los Curie midieron el calor asociado con la desintegración del radio

y establecieron que 1 gramo de radio desprende aproximadamente unos 420 julios

(100 calorías) de energía cada hora. Este efecto de calentamiento continúa hora

tras hora y año tras año, mientras que la combustión completa de un gramo de

carbón produce un total de 34.000 julios (unas 8.000 calorías) de energía. Tras

estos primeros descubrimientos, la radiactividad atrajo la atención de

científicos de todo el mundo. En las décadas siguientes se investigaron a fondo

muchos aspectos del fenómeno.

2

|

TIPOS DE RADIACIÓN

|

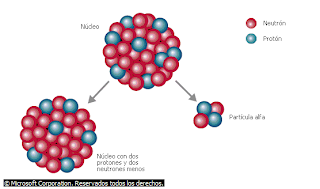

Partículas alfa

Una partícula alfa está formada por

dos protones y dos neutrones que actúan como una única partícula. Son núcleos

de átomos de helio. Cuando un núcleo radiactivo inestable emite una partícula

alfa, éste se convierte en un núcleo de un elemento distinto.

© Microsoft Corporation. Reservados

todos los derechos.

Rutherford descubrió que las

emisiones radiactivas contienen al menos dos componentes: partículas alfa, que

sólo penetran unas milésimas de centímetro en el aluminio, y partículas beta,

que son casi 100 veces más penetrantes. En experimentos posteriores se

sometieron las emisiones radiactivas a campos eléctricos y magnéticos, y estas

pruebas pusieron de manifiesto la presencia de un tercer componente, los rayos

gamma, que resultaron ser mucho más penetrantes que las partículas beta. En un

campo eléctrico, la trayectoria de las partículas beta se desvía mucho hacia el

polo positivo, mientras que la de las partículas alfa lo hace en menor medida

hacia el polo negativo; los rayos gamma no son desviados en absoluto. Esto

indica que las partículas beta tienen carga negativa, las partículas alfa

tienen carga positiva (se desvían menos porque son más pesadas que las

partículas beta) y los rayos gamma son eléctricamente neutros.

Desintegración beta

Hay dos tipos de desintegración beta.

En la que se muestra a la izquierda, un neutrón se convierte en un protón

emitiendo un antineutrino y una partícula beta cargada negativamente. En la de

la derecha, un protón se convierte en un neutrón emitiendo un neutrino y una

partícula beta positivamente cargada. Las partículas beta positivas se llaman

positrones, y las negativas electrones. Después de la desintegración, el núcleo

del átomo contiene un protón más o menos, por lo que constituye un elemento

nuevo, con número atómico distinto.

© Microsoft Corporation. Reservados

todos los derechos.

El descubrimiento de que

la desintegración del radio produce radón demostró de forma fehaciente que la

desintegración radiactiva está acompañada de un cambio en la naturaleza química

del elemento que se desintegra. Los experimentos sobre la desviación de

partículas alfa en un campo eléctrico demostraron que la relación entre la

carga eléctrica y la masa de dichas partículas es aproximadamente la mitad que

la del ion hidrógeno. Los físicos supusieron que las partículas podían ser

iones helio con carga doble (átomos de helio a los que les faltaban dos

electrones). El ion helio tiene una masa unas cuatro veces mayor que el de

hidrógeno, lo que supondría que su relación carga-masa sería efectivamente la

mitad que la del ion hidrógeno. Esta suposición fue demostrada por Rutherford

cuando hizo que una sustancia que emitía partículas alfa se desintegrara cerca

de un recipiente de vidrio de paredes finas en el que se había hecho el vacío.

Las partículas alfa podían atravesar el vidrio y quedaban atrapadas en el

recipiente; al cabo de unos días pudo demostrarse la presencia de helio

elemental utilizando un espectroscopio. Más tarde se demostró que las

partículas beta eran electrones, mientras que los rayos gamma eran radiaciones

electromagnéticas de la misma naturaleza que los rayos X pero con una energía

considerablemente mayor.

2.1

|

La hipótesis nuclear

|

Ernest Rutherford

El físico británico Ernest Rutherford,

que obtuvo el Premio Nobel de Química en 1908, fue un pionero de la física

nuclear por sus investigaciones experimentales y su desarrollo de la teoría

nuclear de la estructura atómica. Rutherford afirmó que un átomo está

constituido en gran medida por espacio vacío, con un núcleo con carga positiva

en el centro, en torno al cual orbitan los electrones, cargados negativamente.

Bombardeando gas nitrógeno con partículas alfa (partículas nucleares emitidas

en procesos radiactivos), Rutherford logró transformar un átomo de nitrógeno en

un átomo de oxígeno y otro de hidrógeno. Este experimento fue un primer

estímulo para el desarrollo de la energía nuclear, que se libera en cantidades

enormes por la desintegración nuclear.

Archive Photos

En la época en que se

descubrió la radiactividad, los físicos creían que el átomo era el bloque de

materia último e indivisible. Después se comprobó que las partículas alfa y

beta son unidades discretas de materia, y que la radiactividad es un proceso en

el que los átomos se transforman (mediante la emisión de una de estas dos

partículas) en nuevos tipos de átomos con propiedades químicas nuevas. Esto

llevó al reconocimiento de que los propios átomos deben tener una estructura

interna, y que no son las partículas últimas y fundamentales de la naturaleza.

En 1911, Rutherford demostró

la existencia de un núcleo en el interior del átomo mediante experimentos en

los que se desviaban partículas alfa con láminas delgadas de metal. Desde

entonces, la hipótesis nuclear ha evolucionado hasta convertirse en una teoría

muy elaborada de la estructura atómica, que permite explicar todo el fenómeno

de la radiactividad. En resumen, se ha comprobado que el átomo está formado por

un núcleo central muy denso, rodeado por una nube de electrones. El núcleo, a

su vez, está compuesto de protones, cuyo número es igual al de electrones (en

un átomo no ionizado), y de neutrones. Estos últimos son eléctricamente neutros

y su masa es aproximadamente igual a la de los protones. Una partícula alfa (un

núcleo de helio con carga doble) está formada por dos protones y dos neutrones,

por lo que sólo puede ser emitida por el núcleo de un átomo. Cuando un núcleo

pierde una partícula alfa se forma un nuevo núcleo, más ligero que el original

en cuatro unidades de masa (las masas del neutrón y el protón son de una unidad

aproximadamente). Cuando un átomo del isótopo de uranio con número másico 238

emite una partícula alfa, se convierte en un átomo de otro elemento, con número

másico 234. (El número másico de un núcleo es el número total de neutrones y

protones que contiene; es aproximadamente igual a su masa expresada en unidades

de masa atómica). Cada uno de los dos protones de la partícula alfa tiene una

carga eléctrica positiva de valor unidad. El número de cargas positivas del

núcleo, equilibrado por el mismo número de electrones negativos en las órbitas

exteriores al núcleo, determina la naturaleza química del átomo. Como la carga

del uranio 238 disminuye en dos unidades como resultado de la emisión

alfa, el número atómico del átomo resultante es menor en dos unidades al

original, que era de 92. El nuevo átomo tiene un número atómico de 90, y es un

isótopo del elemento torio. Véase Elemento químico; Física nuclear.

El torio 234 emite partículas

beta, es decir, electrones. La emisión beta se produce a través de la transformación

de un neutrón en un protón, lo que implica un aumento de la carga nuclear (o

número atómico) en una unidad. La masa de un electrón es despreciable, por lo

que el isótopo producido por la desintegración del torio 234 tiene un

número másico de 234 y un número atómico de 91; se trata de un isótopo del

protactinio.

2.2

|

Radiación gamma

|

Las emisiones alfa y beta

suelen ir asociadas con la emisión gamma. Los rayos gamma no poseen carga ni

masa; por tanto, la emisión de rayos gamma por parte de un núcleo no conlleva

cambios en su estructura, sino simplemente la pérdida de una determinada

cantidad de energía radiante. Con la emisión de estos rayos, el núcleo compensa

el estado inestable que sigue a los procesos alfa y beta. La partícula alfa o

beta primaria y su rayo gamma asociado se emiten casi simultáneamente. Sin

embargo, se conocen algunos casos de emisión alfa o beta pura, es decir,

procesos alfa o beta no acompañados de rayos gamma; también se conocen algunos

isótopos que emiten rayos gamma de forma pura. Esta emisión gamma pura tiene

lugar cuando un isótopo existe en dos formas diferentes, los llamados isómeros

nucleares, con el mismo número atómico y número másico pero distintas energías.

La emisión de rayos gamma acompaña a la transición del isómero de mayor energía

a la forma de menor energía. Un ejemplo de esta isomería es el isótopo

protactinio 234, que existe en dos estados de energía diferentes, y en el

que la emisión de rayos gamma indica la transición de uno al otro.

Los núcleos emiten la

radiación alfa, beta y gamma a velocidades enormes. Las partículas alfa

resultan frenadas y detenidas al pasar por la materia, sobre todo debido a su

interacción con los electrones de dicha materia. Casi todas las partículas alfa

emitidas por una misma sustancia salen de los núcleos con una velocidad

prácticamente igual; por ejemplo, la mayoría de las emitidas por el

polonio 210 viajan 3,8 cm por el aire antes de quedar detenidas

completamente, mientras que las emitidas por el polonio 212 avanzan

8,5 cm. La medida de la distancia recorrida por las partículas alfa se

emplea para identificar isótopos. Las partículas beta se emiten a velocidades

mucho mayores que las partículas alfa, por lo que penetran bastante más en la

materia, aunque el mecanismo de frenado es esencialmente similar. Sin embargo,

a diferencia de las partículas alfa, las partículas beta son emitidas a muchas

velocidades diferentes, y sus emisores se distinguen entre sí por las

velocidades máxima y media características de sus partículas beta. La

distribución de las energías de las partículas beta (y por tanto de sus

velocidades) exige la hipótesis de la existencia de una partícula sin carga ni

masa denominada neutrino; todas las desintegraciones beta están acompañadas de

una emisión de neutrinos. La distancia recorrida por los rayos gamma es varias

veces mayor que la de las partículas beta, y en algunos casos estos rayos

pueden atravesar varios centímetros de plomo. Cuando las partículas alfa y beta

atraviesan la materia originan la formación de numerosos iones; esta ionización

es especialmente fácil de observar cuando la materia es gaseosa. Los rayos

gamma no tienen carga, por lo que no causan tanta ionización. Las partículas

beta producen entre t y z de la ionización generada por las

partículas alfa en cada centímetro de su trayectoria en aire. Los rayos gamma

producen aproximadamente t de la ionización de las partículas beta. El

contador de Geiger-Müller y otras cámaras de ionización (véase Detectores

de partículas) se basan en estos principios y se emplean para detectar las

cantidades de radiación alfa, beta y gamma y, por tanto, la tasa absoluta de

desintegración o actividad de las sustancias radiactivas. Una de las unidades

de actividad radiactiva, el curio, se basa en la tasa de desintegración del

radio 226, que corresponde a 37.000 millones de desintegraciones por

segundo por cada gramo de radio. Véase Efectos biológicos de la

radiación.

Existen formas de desintegración

radiactiva diferentes de las tres que se han mencionado. Algunos isótopos

pueden emitir positrones, que son idénticos a los electrones pero de carga

opuesta. Esta emisión suele clasificarse también como desintegración beta, y se

denomina emisión beta más (β+) o positrón para distinguirla de la

emisión de electrones negativos, más común. Se cree que la emisión de

positrones se lleva a cabo mediante la conversión de un protón del núcleo en un

neutrón, lo que provoca el descenso del número atómico en una unidad. Otra

forma de desintegración, conocida como captura de electrón K, consiste en

la captura de un electrón por parte del núcleo, seguida de la transformación de

un protón en un neutrón. El resultado global también es la reducción del número

atómico en una unidad. Este proceso sólo es observable porque la desaparición

del electrón de su órbita provoca la emisión de rayos X. Algunos isótopos,

en particular el uranio 235 y varios isótopos de los elementos

transuránicos, pueden desintegrarse mediante un proceso de fisión espontánea en

el que el núcleo se divide en dos fragmentos (véase Energía nuclear). A

mediados de la década de 1980, se observó una forma de desintegración única en

la que los isótopos del radio con números másicos 222, 223 y 224 emiten núcleos

de carbono 14 en lugar de desintegrarse en la forma normal emitiendo

partículas alfa.

3

|

PERIODO DE SEMIDESINTEGRACIÓN

|

La desintegración de algunas

sustancias, como el uranio 238 o el torio 232, parece continuar

indefinidamente sin que disminuya de forma detectable la tasa de desintegración

por unidad de masa del isótopo (tasa de desintegración específica). Otras

sustancias radiactivas muestran una marcada reducción de la tasa de

desintegración específica a lo largo del tiempo. Un ejemplo es el isótopo

torio 234 (llamado originalmente uranio X), que una vez separado del

uranio reduce su tasa de desintegración específica a la mitad en 25 días. Cada

sustancia radiactiva tiene un periodo de semidesintegración; en algunos

isótopos es tan prolongado que los métodos actuales no permiten observar la

disminución de la tasa de desintegración específica a lo largo del periodo de

estudio. El torio 232, por ejemplo, tiene un periodo de semidesintegración

de 14.000 millones de años.

4

|

SERIES DE DESINTEGRACIÓN RADIACTIVA

|

Cuando el uranio 238 se

desintegra mediante emisión alfa, se forma torio 234; éste es un emisor

beta y se desintegra para formar protactinio 234, que a su vez, es un

emisor beta que da lugar a un nuevo isótopo del uranio, el uranio 234.

Este isótopo se desintegra mediante emisión alfa para formar torio 230,

que también se desintegra mediante emisión alfa y produce el isótopo

radio 226. Esta serie de desintegración radiactiva, denominada serie

uranio-radio, continúa de forma similar con otras cinco emisiones alfa y otras

cuatro emisiones beta hasta llegar al producto final, un isótopo no radiactivo

(estable) del plomo (el elemento 82) con número másico 206. En esta serie están

representados todos los elementos de la tabla periódica situados entre el

uranio y el plomo, y cada isótopo puede distinguirse por su periodo de

semidesintegración característico. Todos los miembros de esta serie tienen un

rasgo común: si se resta 2 a sus números másicos se obtienen números

exactamente divisibles por 4, es decir, sus números másicos pueden expresarse

mediante la sencilla fórmula 4n + 2, donde n es un

número entero. Otras series radiactivas naturales son la serie del torio,

llamada serie 4n porque los números másicos de todos sus miembros son

exactamente divisibles por cuatro, y la serie del actinio o serie 4n + 3.

El elemento original de la serie del torio es el isótopo torio 232, y su

producto final es el isótopo estable plomo 208. La serie del actinio

empieza con el uranio 235 (llamado originalmente actinouranio por los

investigadores) y acaba en el plomo 207. En los últimos años se ha

descubierto y estudiado en profundidad una cuarta serie, la serie 4n + 1,

en la que todos son elementos radiactivos artificiales. Su miembro inicial es

un isótopo del elemento artificial curio, el curio 241. Contiene el

isótopo más duradero del elemento neptunio, y su producto final es el

bismuto 209.

Una aplicación interesante

del conocimiento de los elementos radiactivos es su uso en la determinación de

la edad de la Tierra. Un método para determinar la edad de una roca se basa en

el hecho de que, en muchos minerales de uranio y torio (que se están desintegrando

desde su formación), las partículas alfa han quedado atrapadas (en forma de

átomos de helio) en el interior de la roca. Determinando con precisión las

cantidades relativas de helio, uranio y torio que hay en la roca, puede

calcularse el tiempo que llevan ocurriendo los procesos de desintegración (es

decir, la edad de la roca). Otro método se basa en la determinación de la

relación que existe en la roca entre las cantidades de uranio 238 y

plomo 206, o de torio 232 y plomo 208 (o sea, las relaciones

entre la concentración de los miembros inicial y final de las series de

desintegración). Estos y otros métodos arrojan valores de la edad de la Tierra

que oscilan en torno a unos 4.600 millones de años. Se han obtenido valores

similares en meteoritos que han caído a la superficie terrestre y en muestras

lunares traídas por el Apolo 11 en julio de 1969, lo que indica que

todo el Sistema Solar tiene probablemente una edad similar a la Tierra.

5

|

RADIACTIVIDAD ARTIFICIAL

|

Irène y Jean Frédéric Joliot-Curie

Irène y Jean Frédéric Joliot-Curie,

una de las más célebres parejas de la historia de la física, en el laboratorio

de la Universidad de París, donde desarrollaron la mayor parte de su actividad

investigadora. En 1933 los dos científicos descubrieron que los elementos

radiactivos se pueden preparar artificialmente a partir de elementos estables.

Bettmann/Corbis

Todos los isótopos naturales

situados por encima del bismuto en la tabla periódica son radiactivos; además,

existen isótopos naturales radiactivos del bismuto, el talio, el vanadio, el

indio, el neodimio, el gadolinio, el hafnio, el platino, el plomo, el renio, el

lutecio, el rubidio, el potasio, el hidrógeno, el carbono, el lantano y el

samario. En 1919, Rutherford provocó la primera reacción nuclear inducida

artificialmente al bombardear gas nitrógeno corriente (nitrógeno 14) con

partículas alfa; comprobó que los núcleos de nitrógeno capturaban estas

partículas y emitían protones muy rápidamente, con lo que formaban un isótopo

estable del oxígeno, el oxígeno 17. Esta reacción puede escribirse en

notación simbólica como ¨N + ¸He → ©O + §Hdonde, por convenio, se escriben los

números atómicos de los núcleos implicados como subíndices y a la izquierda de

sus símbolos químicos, y sus números másicos como superíndices. En la reacción

anterior, la partícula alfa se expresa como un núcleo de helio, y el protón como

un núcleo de hidrógeno.

Hasta 1933 no se demostró

que estas reacciones nucleares podían llevar en ocasiones a la formación de

nuevos núcleos radiactivos. Los químicos franceses Irène y Frédéric

Joliot-Curie produjeron aquel año la primera sustancia radiactiva bombardeando

aluminio con partículas alfa. Los núcleos de aluminio capturaban estas

partículas y emitían neutrones, con lo que se formaba un isótopo de fósforo que

se desintegraba por emisión de positrones, con un periodo de semidesintegración

muy corto. Los Joliot-Curie también produjeron un isótopo de nitrógeno a partir

de boro, y uno de aluminio a partir de magnesio. Desde entonces se han

descubierto muchísimas reacciones nucleares, y se han bombardeado los núcleos

de todos los elementos de la tabla periódica con distintas partículas, entre

ellas partículas alfa, protones, neutrones y deuterones (núcleos de deuterio,

el isótopo de hidrógeno de número másico 2). Como resultado de esta

investigación intensiva se conocen en la actualidad más de 400 elementos

radiactivos artificiales. Esta investigación se ha visto favorecida por el

desarrollo de aceleradores de partículas que comunican velocidades enormes a

las partículas empleadas en el bombardeo, con lo que en muchos casos aumenta la

probabilidad de que sean capturadas por los núcleos utilizados como objetivo.

El estudio de las reacciones

nucleares y la búsqueda de nuevos isótopos radiactivos artificiales, sobre todo

entre los elementos más pesados, llevó al descubrimiento de la fisión nuclear y

al posterior desarrollo de la bomba atómica (véase Energía nuclear;

Armas nucleares). También se descubrieron varios elementos nuevos que no

existen en la naturaleza. El desarrollo de reactores nucleares hizo posible la

producción a gran escala de isótopos radiactivos de casi todos los elementos de

la tabla periódica, y la disponibilidad de estos isótopos supone una ayuda

incalculable para la investigación química y biomédica (véase Isótopo

trazador). Entre los isótopos radiactivos producidos artificialmente tiene gran

importancia el carbono 14, con un periodo de semidesintegración de 5.730 ±

40 años. La disponibilidad de esta sustancia ha permitido investigar con mayor

profundidad numerosos aspectos de procesos vitales, como la fotosíntesis.

En la atmósfera terrestre

existe una cantidad muy pequeña de carbono 14, y todos los organismos

vivos asimilan trazas de este isótopo durante su vida. Después de la muerte,

esta asimilación se interrumpe, y el carbono radiactivo, que se desintegra

continuamente, deja de tener una concentración constante. Las medidas del

contenido de carbono 14 permiten calcular la edad de objetos de interés

histórico o arqueológico, como huesos o momias. Véase Datación.

En el análisis de activación

de neutrones se coloca una muestra de una sustancia en un reactor nuclear para

hacerla radiactiva. Detectando los tipos de radiactividad asociados con los

radioisótopos correspondientes es posible encontrar impurezas que no pueden ser

detectadas por otros medios. Otras aplicaciones de los isótopos radiactivos se

dan en la terapia médica (véase Radiología), la radiografía industrial,

y ciertos dispositivos específicos como fuentes de luz fosforescente,

eliminadores estáticos, calibradores de espesor o pilas nucleares.

Microsoft ® Encarta ® 2009. © 1993--2008 Microsoft Corporation. Reservados

todos los derechos.

http://www.youtube.com/watch?v=pA-aEYgmnq4

Fusión y fisión nuclear

FISIÓN:

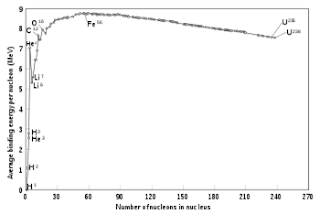

Es el proceso utilizado

actualmente en las centrales nucleares. Cuando un átomo pesado (como por

ejemplo el Uranio o el Plutonio) se divide o rompe en dos átomos más ligeros,

la suma de las masas de estos últimos átomos obtenidos, más la de los neutrones

desprendidos es menor que la masa del átomo original, y de acuerdo con la

teoría de Albert Einstein se desprende una cantidad de Energía que se puede

calcular mediante la expresión E = m C2

Para romper un átomo, se emplea un neutrón porque

es neutro eléctricamente y por tanto, al contrario que el protón o las

partículas alfa, no es repelido por el núcleo. El neutrón se lanza contra el

átomo que se quiere romper, por ejemplo, Uranio-235. Al chocar el neutrón, el

átomo de Uranio-235 se convierte en Uranio-236 durante un brevísimo espacio de

tiempo, como este último átomo es sumamente inestable, se divide en dos átomos

diferentes y más ligeros (por ejemplo Kriptón y Bario o Xenon y Estroncio),

desprendiendo 2 ó 3 neutrones (el número de neutrones desprendidos depende de

los átomos obtenidos, supongamos como ejemplo 3 neutrones). Estos 3 neutrones,

vuelven a chocar con otros 3 átomos de Uranio-235, liberando en total 9

neutrones, energía y dos átomos más ligeros, y así sucesivamente, generandose

de esta forma una reacción en cadena.

Como se puede comprobar, en cada

reacción sucesiva, se rompen 3n átomos, donde n indica 1ª,

2ª, 3ª,..., reacción.

Otra

reacción nuclear de fisión que ocurre en muchos reactores nucleares es:

23592U + n ® 14156Ba + 9236Kr

+ 3n + Energía

En las centrales nucleares

el proceso se modera, evitando la reacción en cadena, para generar energía de

forma lenta, pues de lo contrario el reactor se convertiría en una bomba

atómica. El proceso básico es el siguiente:

Como combustible se utilizan

barras de Uranio enriquecido al 4% con Uranio-235.

El Uranio natural es mayoritariamente U-238, el que es fisionable es el U-235, que es un 0.71% del Uranio que se encuentra en la naturaleza, de ahí que solo un pequeño porcentaje del Uranio se aproveche y se requieran grandes cantidades de este para obtener una cantidad significativa de U-235.

Las barras con el U-235 se introducen en el reactor, y comienza un proceso de fisión. En el proceso, se desprende energía en forma de calor. Este calor, calienta unas tuberías de agua, y esta se convierte en vapor, que pasa por unas turbinas, haciéndolas girar. Estas a su vez, hacen girar un generador eléctrico, produciendo así electricidad. Lógicamente, no se aprovecha toda la energía obtenida en la fisión, parte de ella se pierde en calor, resistencia de los conductores, vaporización de agua, etc.

Los neutrones son controlados para que no explote el reactor mediante unas barras de control (generalmente, de Carburo de Boro), que al introducirse, absorben neutrones, y disminuye el número de fisiones, con lo cual, dependiendo de cuántas barras de control se introduzcan, se generará más o menos energía. Normalmente, se introducen las barras de tal forma, que solo se produzca un neutrón por reacción de fisión, controlando de esta forma el proceso de fisión. Si todas las barras de control son introducidas, se absorben todos los neutrones, con lo cual se pararía el reactor.

El reactor se refrigera, para que no se caliente demasiado, y funda las protecciones, incluso cuando este esté parado, ya que la radiación hace que el reactor permanezca caliente.

El Uranio natural es mayoritariamente U-238, el que es fisionable es el U-235, que es un 0.71% del Uranio que se encuentra en la naturaleza, de ahí que solo un pequeño porcentaje del Uranio se aproveche y se requieran grandes cantidades de este para obtener una cantidad significativa de U-235.

Las barras con el U-235 se introducen en el reactor, y comienza un proceso de fisión. En el proceso, se desprende energía en forma de calor. Este calor, calienta unas tuberías de agua, y esta se convierte en vapor, que pasa por unas turbinas, haciéndolas girar. Estas a su vez, hacen girar un generador eléctrico, produciendo así electricidad. Lógicamente, no se aprovecha toda la energía obtenida en la fisión, parte de ella se pierde en calor, resistencia de los conductores, vaporización de agua, etc.

Los neutrones son controlados para que no explote el reactor mediante unas barras de control (generalmente, de Carburo de Boro), que al introducirse, absorben neutrones, y disminuye el número de fisiones, con lo cual, dependiendo de cuántas barras de control se introduzcan, se generará más o menos energía. Normalmente, se introducen las barras de tal forma, que solo se produzca un neutrón por reacción de fisión, controlando de esta forma el proceso de fisión. Si todas las barras de control son introducidas, se absorben todos los neutrones, con lo cual se pararía el reactor.

El reactor se refrigera, para que no se caliente demasiado, y funda las protecciones, incluso cuando este esté parado, ya que la radiación hace que el reactor permanezca caliente.

En el siguiente esquema, se

muestra cómo trabaja una central nuclear, según lo explicado anteriormente:

A continuación el plano de una

central nuclear, que verifica el esquema anterior.

FUSIÓN NUCLEAR:

La fusión nuclear, está actualmente en líneas de investigación, debido a

que todavía hoy no es un proceso viable, ya que se invierte más energía en el

proceso para que se produzca la fusión, que la energía obtenida mediante este

método.

La fusión, es un proceso natural en las estrellas, produciéndose reacciones nucleares por fusión debido a su elevadísima temperatura interior.

La fusión, es un proceso natural en las estrellas, produciéndose reacciones nucleares por fusión debido a su elevadísima temperatura interior.

Las estrellas están compuestas principalmente por Hidrógeno y Helio. El

hidrógeno, en condiciones normales de temperatura, se repele entre sí cuando

intentas unirlo (fusionarlo) a otro átomo de hidrógeno, debido a su repulsión

electrostática. Para vencer esta repulsión electrostática, el átomo de

hidrógeno debe chocar violentamente contra otro átomo de hidrógeno,

fusionándose, y dando lugar a Helio, que no es fusionable. La diferencia de

masa entre productos y reactivos es mayor que en la fisión, liberándose así una

gran cantidad de energía (muchísimo mayor que en la fisión). Estos choques

violentos, se consiguen con una elevada temperatura, que hace aumentar la

velocidad de los átomos.

La primera reacción de fusión artificial, tuvo origen en la investigación militar, fue una bomba termonuclear (o también llamada bomba-H o de Hidrógeno), para obtener la temperatura adecuada que inicia el proceso de fusión (unos 20 millones de grados centígrados) se utilizó una bomba atómica.

La primera reacción de fusión artificial, tuvo origen en la investigación militar, fue una bomba termonuclear (o también llamada bomba-H o de Hidrógeno), para obtener la temperatura adecuada que inicia el proceso de fusión (unos 20 millones de grados centígrados) se utilizó una bomba atómica.

Ejemplos

característicos de reacciones de fusión son los siguientes:

21D + 21D ®31T + 11H

+ 4.03 MeV

21D + 21D ® 32

He + n + 3.27 MeV

21D + 31T ®42He + n +

17.6 MeV

http://www.youtube.com/watch?v=kFopisjCCXY

TEORIA DEL BIG BANG

Cosmología

1

|

INTRODUCCIÓN

|

Cosmología, estudio del Universo

en su conjunto, en el que se incluyen teorías sobre su origen, su evolución, su

estructura a gran escala y su futuro. Al estudio más específico del origen del

Universo y de sus sistemas astronómicos como el Sistema Solar, se le suele

llamar cosmogonía.

2

|

PRIMERAS TEORÍAS COSMOLÓGICAS

|

Sistemas de Tolomeo y Copérnico

En el siglo II d.C. Claudio Tolomeo

propuso una versión detallada de la visión geocéntrica del Universo, ya antigua

en su época. Este modelo (izquierda) representa a la Tierra inmóvil, con los

planetas, la Luna y el Sol girando a su alrededor. El sistema de Tolomeo fue

aceptado por los astrónomos y los pensadores religiosos durante unos mil años.

En el siglo XVI Nicolás Copérnico resucitó otra idea antigua, el modelo

heliocéntrico del Universo. El nuevo modelo fue rechazado por la Iglesia, pero

poco a poco fue ganando aceptación científica. Los datos de Copérnico no eran

más precisos que los de Tolomeo, pero sus ideas se ajustaban mejor a la nueva

física que se desarrolló en el siglo XVII.

Mary Evans

Picture Library/Photo Researchers, Inc.

Las teorías cosmológicas más

antiguas datan del 4000 a.C., y son las de los pueblos mesopotámicos, que

creían que la Tierra era el centro del Universo y que todos los demás cuerpos

celestes giraban a su alrededor. Algunos clásicos como Aristóteles y el

astrónomo griego Tolomeo, explicaban que las estrellas se movían de noche

porque estaban fijas en esferas rotatorias. El astrónomo griego Aristarco de

Samos, alrededor del 270 a.C., sostenía que la Tierra gira alrededor del

Sol. Sin embargo, debido sobre todo a la autoridad de Aristóteles, la idea de

que la Tierra era el centro del Universo se mantuvo durante 18 siglos.

En 1543 el astrónomo polaco

Nicolás Copérnico publicó su obra De revolutionibus orbium caelestium (Sobre

las revoluciones de los cuerpos celestes), que proponía un sistema en el

cual los planetas giraban en órbitas circulares alrededor del Sol, que estaba situado

en el centro del Universo. Atribuía la posición de las estrellas a la rotación

de la Tierra sobre su eje.

El astrónomo alemán Johannes

Kepler adoptó el sistema copernicano y descubrió que los planetas giran en

órbitas elípticas a velocidad variable, de acuerdo con tres leyes bien

definidas (conocidas desde entonces como leyes de Kepler). Galileo, uno de los

primeros en observar los planetas con un telescopio, también rechazó la idea de

Aristóteles de que la Tierra era el centro del Universo y se convirtió en un

defensor de la visión copernicana del mundo. El matemático y físico inglés

Isaac Newton demostró que las leyes de Kepler sobre el movimiento planetario

podían derivarse de las leyes generales del movimiento y de la gravitación

descubiertas por él, indicando así que estas leyes físicas eran válidas en todo

el Universo. Véase Astronomía.

3

|

DESCUBRIMIENTOS SOBRE LA ESTRUCTURA

DEL UNIVERSO

|

Una idea de la escala

de las distancias entre las estrellas fue proporcionada a principios del siglo

XIX por el astrónomo alemán Friedrich Wilhelm Bessel. Descubrió que la cercana

estrella 61 Cygni estaba unas 600.000 veces más lejos de la Tierra que el

Sol. En 1917 el astrónomo estadounidense Harlow Shapley calculó que la galaxia

de la Tierra, la Vía Láctea, tiene un diámetro de unos 350.000 años luz; ésta

fue la primera indicación del tamaño de nuestra galaxia. Por desgracia, Shapley

no consideró la absorción de la luz de las estrellas por partículas de polvo en

la Vía Láctea, lo que hace que los objetos parezcan más oscuros y, por tanto,

más lejanos de lo que están en realidad. El actual valor del diámetro de la

parte visible de nuestra galaxia es de unos 30.000 parsecs (100.000 años luz).

El astrónomo holandés Jan Hendrik Oort descubrió que el Sol tarda 250.000

millones de años en completar una revolución en torno al centro de nuestra

galaxia y de esta forma pudo calcular que la masa de la Vía Láctea es de unos

100.000 millones de veces la masa del Sol.

Hasta comienzos del siglo

XX, los astrónomos desconocían la naturaleza de lo que describían como

nebulosas espirales y elípticas; no podían determinar si estaban dentro o fuera

de nuestra galaxia. En 1924 el astrónomo estadounidense Edwin Hubble logró

descubrir estrellas individuales en alguno de estos objetos, entre ellos, la

famosa Andrómeda. Varias de estas estrellas eran pulsantes, llamadas variables

cefeidas. Midiendo su periodo de pulsación, los astrónomos pueden determinar su

brillo intrínseco. Comparando el brillo aparente de estas cefeidas con el

brillo conocido de las cefeidas cercanas, Hubble comprobó que los objetos que

estudiaba estaban fuera de la galaxia. Esto significaba que las miles de nebulosas

espirales y elípticas eran galaxias por derecho propio, externas a la Vía

Láctea, y que cada una de ellas contenía cientos de miles de millones de

estrellas. Hubble calculó que la distancia a la galaxia Andrómeda era de

900.000 años luz, cifra después corregida a los 2,2 millones de años luz,

cuando los astrónomos descubrieron que las cefeidas estaban más lejos de lo que

pensaron en un principio.

3.1

|

Ley de Hubble

|

El astrónomo estadounidense

Vesto M. Slipher, que estudió los espectros de las galaxias, ya había observado

en 1912 que, excepto en unos pocos sistemas cercanos como la galaxia Andrómeda,

las líneas espectrales se habían desplazado hacia longitudes de onda mayores (véase

Desplazamiento hacia el rojo). Este desplazamiento en longitud de onda,

debido al efecto Doppler, mostraba que la mayoría de las galaxias se alejaban

de la Vía Láctea.

En 1929 Hubble comparó

las distancias que había calculado para diferentes galaxias con los

desplazamientos hacia el rojo fijados por Slipher para las mismas galaxias.

Descubrió que cuanto más lejos estaba la galaxia, más alta era su velocidad de

recesión. A esta relación se la conoce como la ley de los desplazamientos hacia

el rojo o ley de Hubble; determina que la velocidad de una galaxia es

proporcional a su distancia. La relación entre la velocidad de recesión de una

galaxia y su distancia es la constante de Hubble. El valor de esta constante se

calcula que está entre los 50 y los 100 km/s por megaparsec (1 megaparsec

equivale a 1 millón de parsecs), aunque los datos más recientes apuntan a

un valor comprendido entre los 60 y 70 km/s por megaparsec.

Como parece que las galaxias

retroceden en todas direcciones desde la Vía Láctea, se podría pensar que

nuestra galaxia es el centro del Universo. Sin embargo, esto no es así.

Imaginemos un globo con puntos uniformemente separados. Al inflar el globo, un

observador en un punto de su superficie vería cómo todos los demás puntos se

alejan de él, igual que los observadores ven a todas las galaxias retroceder

desde la Vía Láctea. La analogía también nos proporciona una explicación

sencilla de la ley de Hubble: el Universo se expande como un globo.

4

|

MODELOS ESTÁTICOS Y DE EXPANSIÓN DEL

UNIVERSO

|

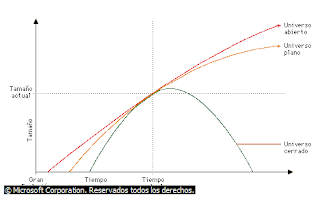

Modelos del Universo

De acuerdo con la teoría generalmente

aceptada de la Gran Explosión, el Universo se originó entre hace 10.000 y

20.000 millones de años atrás y se ha ido expandiendo desde entonces. El futuro

del Universo es incierto: la expansión podría ser limitada (Universo cerrado),

contrayéndose el Universo sobre sí mismo, o podría ser infinita (Universo

abierto), en cuyo caso el Universo seguirá expandiéndose siempre. En el caso

límite entre estas dos posibilidades (Universo plano), tampoco cesará la

expansión.

© Microsoft Corporation. Reservados

todos los derechos.

En 1917 Albert Einstein

propuso un modelo del Universo basado en su nueva teoría de la relatividad

general. Consideraba el tiempo como una cuarta dimensión y demostró que la

gravitación era equivalente a una curvatura del espacio-tiempo cuatridimensional

resultante. Su teoría indicaba que el Universo no era estático, sino que debía

expandirse o contraerse. La expansión del Universo todavía no había sido

descubierta, por lo que Einstein planteó la existencia de una fuerza de

repulsión entre las galaxias que compensaba la fuerza gravitatoria de

atracción. Esto le llevó a introducir una “constante cosmológica” en sus

ecuaciones; el resultado era un universo estático. Sin embargo, desaprovechó la

oportunidad de predecir la expansión del Universo, lo que Einstein calificaría

como “el mayor error de mi vida”.

El astrónomo holandés Willem

de Sitter desarrolló en 1917 modelos no estáticos del Universo. En 1922 lo hizo

el matemático ruso Alexander Friedmann y en 1927 el sacerdote belga Georges

Lemaître. El universo de De Sitter resolvió las ecuaciones relativistas de

Einstein para un universo vacío, de modo que las fuerzas gravitatorias no eran

importantes. La solución de Friedmann depende de la densidad de la materia en

el Universo y es el modelo de universo generalmente aceptado. Lemaître también

dio una solución a la ecuación de Einstein, pero es más conocido por haber

introducido la idea del “núcleo primordial”. Afirmaba que las galaxias son

fragmentos despedidos por la explosión de este núcleo, dando como resultado la

expansión del Universo. Éste fue el comienzo de la teoría de la Gran Explosión

sobre el origen del Universo (véase más adelante).

El destino del universo

de Friedmann está determinado por la densidad media de la materia en el

Universo. Si hay relativamente poca materia, la atracción gravitatoria mutua

entre las galaxias disminuirá las velocidades de recesión sólo un poco y el

Universo se expandirá indefinidamente. Esto dará como resultado un llamado

“universo abierto”, infinito en extensión. Sin embargo, si la densidad de la

materia está por encima de un valor crítico estimado actualmente en

5 × 10-30 g/cm3, la expansión descenderá

hasta detenerse y comenzará la contracción, que acabará en el colapso

gravitatorio total del Universo. Éste sería un “universo cerrado”, finito en

extensión. El destino de este universo colapsado es incierto, pero hay una

teoría según la cual explotaría de nuevo, originando un nuevo universo en

expansión, que se volvería a colapsar, y así hasta el infinito. A este modelo

se le llama universo oscilante o pulsante.

5

|

LA EDAD DEL UNIVERSO

|

Si se conoce la tasa de

expansión del Universo, se puede calcular su edad determinando el tiempo que se

requiere para alcanzar su tamaño actual. Éste será de hecho un límite superior,

cuando la velocidad de expansión actual haya disminuido a causa de la atracción

gravitatoria mutua entre las galaxias. Los primeros cálculos de la edad del

Universo le concedieron un valor de sólo 2.000 millones de años. Esta edad es

bastante menor que la de 4.500 millones de años de la Tierra que se ha deducido

de la abundancia de ciertos isótopos radiactivos (véase Datación).

Correcciones posteriores en la escala de distancias han suprimido esta

discrepancia. Se descubrió, por ejemplo, que hay dos tipos de variables

cefeidas, con brillo intrínseco diferente. Esta confusión había ocasionado que

Hubble subestimara la distancia a la galaxia Andrómeda.

Se considera que la edad

del Universo está entre los 13.500 y los 15.500 millones de años, aunque

mediciones realizadas por la sonda WMAP (Wilkinson Microwave

Anisotropy Probe) de la radiación de fondo de microondas permitieron, en

febrero de 2003, acotar ese tramo y fijar su edad en 13.700 millones de años,

con un margen de error de un 1%. Esta sonda fue lanzada por la NASA en junio de

2001, y sus observaciones permitieron también precisar que las primeras

estrellas se formaron unos 200 millones de años después del Big Bang,

mucho antes de lo que se creía.

6

|

LA TEORÍA DEL UNIVERSO ESTACIONARIO

|

Sir Fred Hoyle

El astrónomo inglés Fred Hoyle es

autor de muchas teorías controvertidas. La más famosa es la teoría del universo

estacionario o 'principio cosmológico perfecto', según el cual el Universo

siempre se percibe de la misma manera, pues la disminución de densidad debida a

la expansión está exactamente compensada por la creación continua de materia.

Ésta se condensa en galaxias que ocupan el lugar de las que se han alejado de

la Vía Láctea, y se mantiene así el aspecto actual del Universo.

Corbis

En 1948, los astrónomos

británicos Hermann Bondi, Thomas Gold y Fred Hoyle presentaron un modelo

completamente distinto de universo, conocido como la teoría del universo

estacionario. Consideraban insatisfactoria, desde el punto de vista filosófico,

la idea de un repentino comienzo del Universo. Su modelo se derivaba de una

extensión del “principio cosmológico”, que en su forma previa, más restringida,

afirmaba que el Universo parece el mismo en su conjunto, en un momento

determinado desde cualquier posición. El “principio cosmológico perfecto” de

Bondi, Gold y Hoyle añade el postulado de que el Universo parece el mismo

siempre. Plantean que la disminución de la densidad del Universo provocada por

su expansión se compensa con la creación continua de materia, que se condensa

en galaxias que ocupan el lugar de las galaxias que se han separado de la Vía

Láctea y así se mantiene la apariencia actual del Universo (es la teoría de

creación continua). La teoría del universo estacionario, al menos en esta

forma, no la aceptan la mayoría de los cosmólogos, en especial después del

descubrimiento aparentemente incompatible de la radiación de fondo de

microondas en 1965.

El descubrimiento de quasares

también aportó pruebas que contradicen la teoría del universo estacionario. Los

quasares son sistemas extragalácticos muy pequeños pero muy luminosos que

solamente se encuentran a grandes distancias. Su luz ha tardado en llegar a la

Tierra varios miles de millones años. Por lo tanto, son objetos del pasado

remoto, lo que indica que hace unos miles de millones de años la constitución

del Universo era muy distinta de lo que es hoy en día.

7

|

LA TEORÍA DEL BIG BANG O DE LA GRAN

EXPLOSIÓN

|

En 1948 el físico ruso

nacionalizado estadounidense George Gamow modificó la teoría de Lemaître del

núcleo primordial. Gamow planteó que el Universo se creó en una explosión

gigantesca y que los diversos elementos que hoy se observan se produjeron

durante los primeros minutos después de la Gran Explosión o Big Bang,

cuando la temperatura extremadamente alta y la densidad del Universo fusionaron

partículas subatómicas en los elementos químicos. Cálculos más recientes

indican que el hidrógeno y el helio habrían sido los productos primarios de la

Gran Explosión, y los elementos más pesados se produjeron más tarde, dentro de

las estrellas (véase Nucleosíntesis). Sin embargo, la teoría de Gamow

proporciona una base para la comprensión de los primeros estadios del Universo

y su posterior evolución. A causa de su elevadísima densidad, la materia existente

en los primeros momentos del Universo se expandió con rapidez. Al expandirse,

el helio y el hidrógeno se enfriaron y se condensaron en estrellas y en

galaxias. Esto explica la expansión del Universo y la base física de la ley de

Hubble.

Según se expandía el Universo,

la radiación residual de la Gran Explosión continuó enfriándose, hasta llegar a

una temperatura de unos 3 K (-270 °C). Estos vestigios de radiación

de fondo de microondas fueron detectados por los radioastrónomos en 1965, proporcionando

así lo que la mayoría de los astrónomos consideran la confirmación de la teoría

de la Gran Explosión.

8

|

EVOLUCIÓN DEL UNIVERSO

|

Uno de los problemas sin

resolver en el modelo del Universo en expansión es si el Universo es abierto o

cerrado (esto es, si se expandirá indefinidamente o se volverá a contraer).

Un intento de resolver

este problema es determinar si la densidad media de la materia en el Universo

es mayor que el valor crítico en el modelo de Friedmann. La masa de una galaxia

se puede medir observando el movimiento de sus estrellas; multiplicando la masa

de cada galaxia por el número de galaxias se ve que la densidad es sólo del 5

al 10% del valor crítico. La masa de un cúmulo de galaxias se puede determinar

de forma análoga, midiendo el movimiento de las galaxias que contiene. Al

multiplicar esta masa por el número de cúmulos de galaxias se obtiene una

densidad mucho mayor, que se aproxima al límite crítico que indicaría que el

Universo está cerrado. La diferencia entre estos dos métodos sugiere la

presencia de materia invisible, la llamada materia oscura, dentro de cada

cúmulo pero fuera de las galaxias visibles. Hasta que se comprenda el fenómeno

de la masa oculta, este método de determinar el destino del Universo será poco

convincente.

Muchos de los trabajos

habituales en cosmología teórica se centran en desarrollar una mejor

comprensión de los procesos que deben haber dado lugar a la Gran Explosión. La

teoría inflacionaria, formulada en la década de 1980, resuelve dificultades

importantes en el planteamiento original de Gamow al incorporar avances

recientes en la física de las partículas elementales. Estas teorías también han

conducido a especulaciones tan osadas como la posibilidad de una infinidad de

universos producidos de acuerdo con el modelo inflacionario. Sin embargo, la

mayoría de los cosmólogos se preocupa más de localizar el paradero de la

materia oscura, mientras que una minoría, encabezada por el sueco Hannes

Alfvén, premio Nobel de Física, mantienen la idea de que no sólo la gravedad

sino también los fenómenos del plasma, tienen la clave para comprender la

estructura y la evolución del Universo.

Microsoft ® Encarta ® 2009. © 1993--2008 Microsoft Corporation. Reservados

todos los derechos.

http://www.youtube.com/watch?v=KP9R4RL60Ms&feature=fvst

http://www.youtube.com/watch?v=KP9R4RL60Ms&feature=fvst